|

|

|

Корогодин В.И., Корогодина В. Л.

КОРОГОДИН В. И., КОРОГОДИНА В. Л.

Информация как основа жизни. – Дубна: Издательский центр «Феникс», 2000. – 208 с.

Книга посвящена феномену жизни и информации как внутренне присущему свойству информационных систем.

Рассматриваются свойства информации и информационных систем. Выделяются главные свойства информационных систем – способность к «целенаправленным» действиям и расслоение на информационную» и «динамическую» подсистемы.

Рассматривается динамика информации от ранних этапов эволюции физических информационных систем до систем с биологической информацией – генетической, поведенческой и логической. Особое внимание уделяется динамике биологической информации в биосфере. Одной из проблем, затрагиваемой авторами, является взаимодействие ноосферы и техносферы, связанной с автогенезом информации.

Книга рассчитана на специалистов, а также на круг читателей, интересующихся теорией информации, эволюцией, биологией и взаимоотношениями биосферы и техносферы.

KOROGODIN V.I. & KOROGODINA V.L. Information as the Foundation of Life. – Dubna: "Phoenix" Publishing Center, 2000. – 208 p.

The book analyzes the phenomenon of life and information as an inherent quality of information systems.

Properties of information and information systems are discussed. The main properties of information systems are pointed out: the ability to act "purposefully" and the division into an "informative" and "dynamic" subsystems.

The dynamics of information is analyzed, from the early stages of physical information system evolution to the systems with biological genetic, be-haviouristic and logical information. Special attention is attached to the dynamics of biological information in biosphere. One of the problems, connected with information autogenesis and discussed by the authors, is the interaction of noosphere and technosphere with biosphere.

The book is recommended to specialists and readers who are interested in the theory of information, evolution, biology and interaction of biosphere and technosphere.

© Авторы. В. И. Корогодин и В. Л. Корогодина, 2000 г. © Оформление. ИЦ «Феникс», 2000 г.

Оглавление

Глава первая. Историческая справка

Глава вторая. Информация и ее свойства

Глава третья. Информационные системы

Глава четвертая. Принцип поризма

Глава пятая. Динамика информации

Глава шестая. Биосфера и техногенез

Глава седьмая. Предвидимо ли будущее?

Обозначение используемых понятий

Contents

Prolegomenon

Chapter 1. History

Chapter 2. Information and Its Properties

Chapter 3. Information Systems

Chapter 4. Porism Principle

Chapter 5. Dynamics of Information

Chapter 6. Biosphere and Technogenes

Chapter 7. Can One Predict the Future

Designation of the Notions Used

Термин «информация»

Термин «информация» широко используется в научной литературе. Трудно найти область знаний, избежавшую соблазна его применять. Это – следствие все продолжающегося расширения смыслового поля этого термина.

В тридцатые годы и ранее слово «информация» использовали, в основном, как «сведения» или «осведомление», т.е. как прямой перевод латинского informatio. К концу сороковых годов под «информацией» начали понимать функцию статистических характеристик букв какого-либо языка. Так, согласно К. Шеннону [1], количество информации, содержащейся в каком-либо сообщении, состоящем из М букв, равно

![]() (1)

(1)

где п – число букв в данном языке, ар– частота встречаемости i–той буквы (i=1,2...n) в этом языке. Знак минус поставлен перед правой частью формулы для того, чтобы количество информации Н всегда было положительным.

Под влиянием работ Л. Бриллюэна [2], начиная с шестидесятых годов, возник и приобрел широкую известность «негэнтропийный принцип информации». В отличие от энтропии, рассматриваемой в качестве меры неупорядоченности той или иной системы, негэнтропией обычно называют меру упорядоченности окружающих нас систем, связывая с ней различного рода антиэнтропийные процессы, протекающие в физическом мире. В основе негэнтропийного принципа лежит формальное сходство обобщенной формулы К. Шеннона

![]()

![]() (2)

(2)

и знаменитой формулы Больцмана для физической энтропии S = lnW, где W - число состояний, которые может принимать система. Если микросостояния системы различны, то формула будет выглядеть так

![]() (3)

(3)

Л. Бриллюэн предложил выражать информацию I и энтропию S в одних и тех же единицах - информационных (битах) или энтропийных (эрг/град).

Б. Б. Кадомцев указывает [3], что величины I и S формально равны потому, что I соответствует информации одного единственного состояния из множества возможных, a S определена по множеству всех состояний. Здесь понятие информации дается в терминах физической статистики. Алгоритмическую информацию можно рассматривать как меру алгоритмической хаотичности [4]. Эти два определения практически совпадают [5].

Однако существуют области феноменов, для обозначения которых этот термин также хорошо подходит, и использование его существенно упрощает задачи их изучения.

Жизнь вокруг нас

Замечали ли вы когда-нибудь, что в русском языке нет слова, противоположного словам «живое», «жизнь»? Вернее, есть слова «мертвое», «смерть», но они означают лишь то, что когда-то было живым, а затем погибло. «Неживое» также происходит от слова «живое». И этот характерный для многих языков феномен связан, видимо, с тем, что, склонный судить о других по себе, первобытный человек одушевлял, по аналогии с собой, весь окружающий мир [6].

Со временем представления о всеобщей одушевленности сменились представлениями о постепенности переходов неживого к живому. Так, Г. Лейбниц считал, что не существует неорганического царства, а есть только одно громадное органическое, различные ступени которого представлены в минералах, растительных и животных формах. Всюду в мире наблюдается непрерывность, и всюду, где мы встречаемся с какой-нибудь организацией, существует и жизнь. Мертвая и живая материи не суть какие-нибудь противоположности, но представляют собой две формы той же материи, отличающиеся друг от друга только оттенками.

Но философы пошли еще дальше по пути аналогий. В игре сил мертвой материи, и главным образом в игре химических сил, они увидели чуть заметный зародыш тех склонностей и стремлений, которые управляют деятельностью живых существ. По их мнению, все реакции материи указывают на существование в ней какого-то сознания, способности отличать дурное от хорошего, стремиться к приятному, избегать неприятного. Таково было мнение Эмпедокла еще в древности; так же считали Д. Дидро и Ц. Кабанис. Еще на заре химии Л. Бергав, например, сравнивал реакции соединения с сознательными союзами, причем соединявшиеся «по симпатии» химические элементы чуть ли не справляли свадьбу.

Живое и неживое

Одна из особенностей живых тел – их изменяемость во времени: рождение, рост, старение, умирание и распад. Но ведь рождение и гибель касаются всех тел Вселенной – от атомов до галактик. Любой материальный объект «живет и умирает» в том смысле, что он непрерывно изменяется в одном и том же направлении, пока не достигнет состояния «вечного покоя».

Постоянство формы, рост, питание и размножение – таковы обязательные признаки жизни. Может быть, они обусловлены особым химическим строением? Но еще в середине прошлого века ученые выяснили, что протоплазма живой клетки, состоящая из углерода, водорода, азота, кислорода, фосфора и серы, в химическом отношении близка к ароматическим соединениям. Сейчас досконально изученное в организме строение белков, жиров, углеводов и нуклеиновых кислот показывает, что они не отличаются от своих неживых аналогов, образующихся под влиянием высоких температур или электрических разрядов. Их можно получать даже «в пробирках», по заранее составленному плану.

Специфичны ли для живых тел эти основные признаки? Вспомним о кристаллах. Давно известно, что каждый кристалл имеет строго определенную форму. Мало того. Если форма кристалла нарушена, например, отбит кусочек, – достаточно поместить его в раствор того же вещества, и он, подобно ящерице с оторванным хвостом, будет восстанавливать повреждение. Уже это говорит о его способности к своего рода питанию – поглощению из окружающей среды нужных ему компонентов. И только после того, как ущерб ликвидирован, кристалл будет расти, пока не исчерпает «питательность» содержащего его раствора. Так же обстоит дело и с размножением: кто не видел друзы кристаллов, образующихся из пересыщенного раствора поваренной соли или сахара?

Все это означает, что такие специфичные признаки живого (постоянство формы, рост, регенерация, питание, размножение, старение, гибель и др.) характерны не только для живых организмов, но и для ряда заведомо неживых кристаллов. Но кристаллы, скажут нам, могут сохраняться в неизменном виде неограниченно долгое время, в отличие от живых существ. А сохранность сухих зерен в египетских пирамидах или хорошо высушенных коловраток, особенно при низких температурах? Когда организмы находятся в анабиозе, в состоянии «скрытой жизни», они могут оставаться без изменения годы и годы и вновь начинают «жить» только при подходящей температуре, влажности и наличии питания. Но так же ведут себя и кристаллы! Значит, очень многие свойства живого присущи и неживым телам.

Чем же тогда, действительно, отличаются живые организмы от неживых тел? Может быть, какими-либо особенностями тех же функций, которые свойственны и неживым кристаллам, например определенными требованиями к внешней среде, температуре, концентрации каких-либо веществ? Но как экспериментально показали такие крупные химики, как Ж. Жерне, К. Дюфур, В. Освальд и другие, и в этом отношении принципиальных различий нет. Так, процессы кристаллизации или размножения кристаллов очень чувствительны к температуре, концентрации раствора и наличию примесей, подобно тому, как эти же факторы влияют на скорость размножения микроорганизмов, помещенных в питательный бульон. Более того, подбирая специальные условия среды, можно получить химические образования, ведущие себя внешне неотличимо от живых организмов.

Что же такое живое?

И все же эти размышления о свойствах живого ни на шаг не приближают нас к ответу на вопрос: что такое живое? Конечно, отдельные признаки живых организмов можно найти и у неживых объектов, но то, что разделяет их, остается непонятным. По такому пути традиционное мышление шло до самого последнего времени. И хотя сегодня мы знаем, из каких химических соединений построено живое, что представляет собой дыхание, питание, выделение «отработанных шлаков», как происходит деление клетки, размножение одноклеточных и высших организмов, какие при этом идут молекулярные процессы, точного определения живого еще нет.

«Жить – значит обладать способностью откликаться более или менее целесообразно на воздействия окружающей обстановки», – писал К. Платэ, несколько видоизменив определение живого, предложенное английским философом Г. Спенсером, который полагал, что «жизнь есть определенное сочетание разнородных изменений, одновременных и последовательных, в соответствии с внешними сосуществованиями и последовательностями». По поводу этого определения жизни наш замечательный натуралист В. В. Лункевич [7] остроумно заметил, что оно дает нам «и очень много, и ничего». Очень много, потому что объединяет в единое целое все возможные проявления жизни, и ничего, потому что оставляет в стороне вопрос о причинах, их вызывающих.

По-видимому, нужно идти другим путем. Попробуем найти такое специфическое свойство, отличающее живое от неживого, обладание которым делает объект живым. Эта искомая сущность должна объяснить все проявления жизни, включая способность к прогрессивной эволюции. Среди самых разных свойств живого должно быть одно, объединяющее все многообразие живых существ. Свойство это давно известно, но почему-то до сих пор приписывалось только человеку. Это – способность совершать целенаправленные действия.

«Учение о цели» (телеология) восходит к доаристотелевским временам, когда движение небесных светил и невидимых атомов объясняли существованием единой «движущей силы», находящейся вне «материальных оболочек» привычных и знакомых всем вещей. Лишь с течением времени физики избавили неживой мир от влияния «единого движителя», и в его ведении осталась лишь живая природа. Эта одухотворяющая сила во времена Аристотеля, т.е. более 2000 лет назад, получила наименование «энтелехия». Такие представления под другими названиями просуществовали до начала нашего века [8], но в дальнейшем энтелехия сошла со сцены. На виду осталось очевидное – способность совершать целенаправленные действия. Если не связывать эту способность с сознательным стремлением к цели, то почти не нужно доказывать, что она присуща всем без исключения живым организмам.

Целенаправленное действие и его компоненты

Чем же «целенаправленное действие» отличается от других событий, происходящих вокруг нас?

Идет гроза, ветер гнет деревья, раздается грохот грома, молния ударяет в деревянный сарай, и начинается пожар. Можем ли мы по отношению к таким событиям сказать для чего они происходят? Нет, конечно. Мы полностью объясним эти события, если ответим на вопрос: почему'?

Но таким событиям противостоят другие, которые нельзя объяснить, ответив только на вопрос «почему?» и умолчав «для чего?» Это события, идущие с участием живых организмов: когда вирусная частица, прикрепившись к поверхности бактерии, впрыскивает в нее свою ДНК; когда муравьи роют вход в подземный муравейник; когда птица строит гнездо, зверь – нору или человек засевает зерном взрыхленное поле. Во всех подобных случаях, чтобы понять действия живых существ, следует знать, для чего они это делают. Подчас этого ответа достаточно, чтобы понять природу наблюдаемого явления.

Здесь напрашивается аналогия с машинами, изготовляемыми человеком, да и другими изделиями, которые производят разные живые существа – от насекомых до высших млекопитающих: термитниками и муравейниками, гнездами и норами, различными постройками и т.п. В таких случаях прежде всего решают вопрос, для чего они предназначены, а уже затем – почему и как. Цель стоит впереди, а уж насколько то или иное изделие будет ей соответствовать, зависит от искусства его творца. Поэтому-то такие изделия и называют искусственными.

Итак, «искусственный» – термин, применяемый к объекту, изготовленному каким-либо живым организмом согласно «своему желанию», для достижения своей цели – удовлетворить потребность живого. Но таким целям служат, по существу, любые действия, совершаемые живыми организмами, как бы ни был широк их диапазон. Эти целенаправленные действия далеко не всегда однозначно связаны с «конечной целью» – той именно потребностью, которую организм стремится удовлетворить, даже не осознавая этого. Но стоит внимательно понаблюдать за любым живым существом, и станет ясно, что все «конечные цели» сводятся к одной – оставить потомство. Поэтому можно сказать, что живое – это совокупность объектов, способных совершать целенаправленные действия, конечная цель которых – самовоспроизведение.

Целенаправленное действие отличается от спонтанного течения событий прежде всего тем, что оно повышает вероятность осуществления «события цели». Насколько повысится эта вероятность – зависит от искусства исполнителя, от степени его осведомленности о путях достижения цели и о наличии в его распоряжении необходимых ресурсов. Но, независимо от этого, любое целенаправленное действие характеризуется именно повышением вероятности достижения цели, и величина эта позволяет судить об его эффективности [9].

Вторая характеристика целенаправленного действия – те дополнительные изменения в окружающей среде, которые его сопровождают. При любом целенаправленном действии всегда (в соответствии со вторым законом термодинамики) появляются «побочные продукты» – от едва заметного повышения температуры окружающей среды до накопления в этой среде веществ, отравляющих все живое. Чем совершеннее методы достижения цели, тем меньше образуется побочных продуктов.

И, наконец, самое главное в целенаправленном действии – это механизм, который его осуществляет. Такой механизм можно назвать «оператором» [10]. В искусственных устройствах – это машина, изготовленная человеком, или какое-либо иное сооружение, сделанное живыми существами, а в живых организмах это сам организм, его тело, его строение, его навыки и умение пользоваться имеющимися ресурсами для достижения своей цели. Все мы прекрасно знаем, сколь различны организмы по размеру, форме и образу действий и как превосходно они пригнаны к среде своего обитания, своей «экологической нише». И чем больше такое соответствие, тем успешнее они достигают цели и тем менее пагубны побочные продукты, это сопровождающие.

Информационные системы

Остановимся подробнее на появлении информационных систем – процессе самоорганизации. Как показал И. Пригожий [11], это должны быть открытые системы, далекие от термодинамического равновесия. В такой системе должны иметь место каталитические и кросс-каталитические процессы. Такие процессы хорошо описываются нелинейными дифференциальными уравнениями. Когда система становится неустойчивой, любые малые возмущения во внешней среде приведут к переходу в новое стационарное состояние. Под влиянием возникающих в это время флуктуации элементы ансамбля могут «кооперироваться», что будет проявляться в новых системных свойствах. В этом процессе необходимо подчеркнуть следующее.

Критерием эволюции является принцип о минимальном производстве энтропии. Он указывает на то, что направленное развитие термодинамической системы происходит вне равновесного состояния и поддерживается слабыми, но постоянными силами. Когда система встречает препятствия к достижению идеального состояния минимального рассеяния, она начинает выбирать следующий наилучший путь и остается в состоянии минимального рассеяния и минимального производства энтропии. Т.е. самоорганизующаяся система появляется всегда, когда возможно «выжить» за счет своих кооперативных свойств при различных воздействиях или для того, чтобы лучше использовать окружающую среду [11-13]. Это можно считать обоснованием «целенаправленного» действия для любых самоорганизующихся систем.

Любое целенаправленное действие можно описать преобразованием

![]() (4)

(4)

где R - ресурсы, расходуемые на его осуществление; s - условия среды, в которой это действие происходит; Q - объект, или оператор, это действие осуществляющий и построенный согласно некоторому определенному плану, или информации, I - событие цели; w - «побочный продукт», сопровождающий осуществление Z; р и Р - вероятность осуществления Z спонтанно и/или при участии оператора Q. Мы видим, что единственное отличие целенаправленного действия от естественного течения событий состоит в том, что оператор Q, его совершающий, построен на основании данной информации. Только это приводит к тому, что в некоторой ситуации s вероятность осуществления Z при участии Q выше, чем в его отсутствие (Р>р). Яркий пример этому – размножение живых организмов. В отсутствие в данной среде s живых организмов они не способны возникать спонтанно, «самозарождаться», т.е. р=0 даже при самых подходящих внешних условиях. Размножение же живых существ в подходящих условиях среды происходит с вероятностью Р, близкой к единице.

Роль информации в явлении размножения первым отметил, пожалуй, Дж. фон Нейман [14]. Выступая в Калифорнийском технологическом институте на симпозиуме «Механизмы мозга в поведении» с лекцией «Общая и логическая теория автоматов» (1948 г.), он впервые предложил описание универсального самовоспроизводящего автомата. Дж. фон Нейман отметил, что такой воспроизводящийся автомат, по существу, имеет структуру, подобную структуре живых организмов. Мы можем добавить, что этот автомат можно рассматривать как устройство, призванное обеспечить размножение, или аутокатализ, кодирующей его информации. Автомат имеет блок, отвечающий за создание оператора Q и автомата следующего поколения на основе ресурсов R. В живой клетке этот блок организует «метаболизм», и через него осуществляется отбор наилучших образцов. Если посмотреть на автомат фон Неймана с этой точки зрения, то очевидно, что он – схематическое отображение любых информационных систем, устроенных так, чтобы они могли обеспечивать воспроизведение кодирующей их информации. Вирусы и одноклеточные живые существа, многоклеточные растения и грибы, многоклеточные животные, наконец, человек и человеческие сообщества – все это информационные системы, структура которых задается относящейся к ним информацией, а функция обеспечивает воспроизведение этой информации.

В процессе дублирования исходной информации или при передаче ее из одного автомата в другой она может претерпеть изменения, и возможны три последствия: 1) либо новый автомат не сможет воспроизвести самого себя, и вся система погибнет; 2) либо автомат начнет «неправильно работать» и будет производить обреченных на гибель уродцев; 3) либо эти изменения окажутся жизнеспособными, и возникнет новый автомат, воспроизводящий новую, измененную информацию.

Как мы видели, самовоспроизведение автомата Q и кодирующей его информации I всегда и неизбежно сопровождается появлением «побочных продуктов» w. Это результат того факта, что КПД любого материального процесса не может превысить 1, а точнее – всегда остается меньше 1. Любое действие всегда сопровождается появлением «побочных продуктов», от диссипации энергии до накопления в окружающей среде различных «отходов производства», возникающих в ходе построения Q. Любая информационная система, таким образом, в ходе своего функционирования, направленного на ее самовоспроизведение, неизбежно изменяет окружающую среду 5 путем истощения ее ресурсов R и накопления в ней «побочных продуктов» w.

Здесь мы можем вспомнить Н.Винера [15]: «Информация – это обозначение содержания, полученного из внешнего мира в процессе нашего приспособления к нему». Но чтобы не придавать информации антропоморфный оттенок, что проступает у Н. Винера, можно предложить несколько иное определение. А именно: информацией можно назвать алгоритм построения системы, обеспечивающей воспроизведение этой информации, функционально связанной со средой своего местоположения. При этом следует подчеркнуть, что обеспечение воспроизведения информации – обязательный и необходимый атрибут любой информационной системы. Ведь система, не отвечающая этому требованию, неизбежно «выбывает из игры», а кодирующая ее информация разрушается и бесследно исчезает. Именно исчезает, а не переходит во что-то другое, – ведь «информация есть информация, а не материя и не энергия» [15], и законы сохранения на нее не распространяются [16].

Информация и ее носители

Остановимся коротко на структуре информационных систем и носителях информации.

После публикации работы К. Шеннона [1] понятие «информация» было очень быстро вытеснено понятием «количество информации». За «количество информации», согласно формуле (1), принимали логарифм величины, обратной вероятности осуществления какого-либо события. Такую подмену понятий стали использовать очень широко. Такой подход привел к отрыву понятия «информация» от семантики, или содержания сообщений, искони ему присущего. Подчеркнем, что в данном примере мы не можем выделить смысл (семантику) сообщения, не взяв для этого всех букв текста, являющихся носителями информации.

Рассмотрим пример информационных процессов из газодинамики (подробно см. [3]). В общем случае поведение разреженного газа описывается кинетическим уравнением Больцмана

![]() (5)

(5)

где f – локальная функция распределения частиц по скоростям, a St(f) – член столкновения между атомами. Если столкновения часты, то функция распределения становится максвелловской и зависит от п, Т, и – локальных значений плотности, температуры и средней скорости. Если эти переменные являются функциями координат и времени, то уравнение Больцмана превращается в систему

![]()

![]() где

где ![]()

![]() где

p = nT

где

p = nT

Увеличение члена столкновений St(f) выделило набор величин п, Т, и, которые стали динамическими переменными. Их можно назвать параметрами порядка.

Мы дали описание открытой системы, далекой от равновесия. Если мы пойдем по пути усложнения системы, то заметим, что можно выделить часть, более тонко реагирующую на возмущения. Ее можно назвать управляющей, информационной частью, передающей сигналы в динамическую часть.

Теперь перейдем к генетической информации, носителями которой являются молекулы ДНК. Слова «ДНК», «гены», «наследственная информация» стали настолько привычными, что нередко воспринимаются как синонимы. В действительности это далеко не так. Гигантская по длине молекула ДНК состоит из четырех типов «кирпичиков», или нуклеотидов, которые могут быть соединены в любой последовательности. Эти молекулы обладают свойством, которое Г.Меллер назвал аутокатализом. Если в раствор, содержащий такие молекулы, внести в должном количестве все четыре нуклеотида (основания), то при соблюдении некоторых дополнительных условий эти молекулы начнут пристраивать основания вдоль своей цепи точно в той же последовательности, как и в них самих, а затем отделять от себя готовые копии. Процесс этот не зависит от того, какова последовательность оснований, составляющих исходные молекулы ДНК. Это может быть случайная последовательность, или строго чередующаяся, или любая иная – копии будут всегда похожи на оригинал, если не произойдет мутации, т.е. случайной замены, вставки или выпадения одного или нескольких оснований.

Если ДНК состоит из случайной последовательности оснований, это далеко не ген, поскольку никакой наследственной информации она не содержит, хотя и может самовоспроизводиться. Информация возникает на отрезках молекулы ДНК лишь тогда, когда благодаря мутированию (или по иным причинам) там сложится такая последовательность оснований, которая сможет повлиять на химические процессы, протекающие в ее окружении. Только тогда, выступая в роли «катализатора», ген сможет ускорить одни или притормозить другие процессы, изменяя тем самым свое химическое окружение. Постепенно все большие преимущества будут получать такие структуры ДНК, которые в непосредственном своем окружении могут увеличивать концентрацию нуклеотидов и других веществ, необходимых для их размножения. Лишь когда этот процесс завершится и в «первичной» молекуле ДНК возникнут отрезки, каждый из которых стимулирует образование необходимых для удвоения ДНК соединений или угнетает синтез соединений, препятствующих их удвоению, можно считать, что в молекуле ДНК возникли гены и что сама эта молекула стала носителем генетической информации.

Генетическая информация, следовательно, содержится в наборе генов, контролирующих синтез соединений, которые обеспечивают удвоение молекул ДНК в некоторых данных условиях. Появление генов тесно связано с возникновением аппарата трансляции, а также с формированием оболочек или мембран, отделяющих от внешней среды участок, где находятся молекулы ДНК [17]. Это уже возникновение живых объектов, которые могут расти, размножаться и приспосабливаться к новым условиям благодаря генам, возникающим и изменяющимся в результате мутаций; они умирают, когда разрушаются содержащиеся в них гены или когда они не в состоянии приспособиться к внешним условиям. Изменяясь, гены влияют и на другие структуры организма, обеспечивая тем самым «заселение» все новых мест обитания, появление многоклеточных растений, грибов и животных, т.е. эволюцию жизни на Земле. Как писал Г. Меллер, в основе жизни лежит ген.

Таким образом, совокупность генов, или генетическая информация, регулирующая целенаправленную деятельность любой живой клетки, определяется не самими основаниями ДНК, а последовательностью их расположения.

Различие между генетической информацией и молекулой ДНК позволяет также ввести понятие генетической информации и выяснить отличие таких ее носителей от информации как таковой. Поэтому-то мы и говорим, что генетическая информация записана в ДНК определенной последовательностью оснований. Именно эта информация, т.е. запись последовательности тех событий, которые должны произойти, чтобы вновь возникающие клетки могли вырасти, а затем вновь поделиться и т.д., – самый важный компонент живой клетки. То, о чем писал Меллер около 70 лет назад, можно сформулировать следующим образом: живое - это совокупность объектов, содержащих информационные структуры, обладающие свойствами аутокатализа и гетерокатализа, обеспечивающие размножение этих объектов в разнообразных условиях внешней среды. Жизнь – это возникновение все новых содержащих информацию объектов, материальные компоненты которых обеспечивают ее воспроизведение во все более разнообразных и сложных ситуациях. Очевидно, что чем сложнее эти ситуации, тем больше нужно информации, чтобы в соответствии с ней построить живой объект, способный в этих ситуациях существовать.

Как нам кажется, в мире неживой Природы нет примеров информационных систем, в которых носители информации отличались бы качественно от остальных элементов системы.

Основа жизни

Мы привыкли к словосочетанию «генетическая информация», забыли даже, что ввел его в научный обиход Э. Шредингер в середине 40-х годов [18]. В своей книге «Что такое жизнь с точки зрения физика?» он опирался на работу Н. В. Тимофеева-Ресовского, К. Г. Циммера и М. Дельбрюка «О природе генных мутаций и структуре гена», увидевшую свет в Германии в 1935 г. [19]. Это произошло вскоре после того, как Г. Меллер, ученик Т. Моргана, впервые показал, что гены не только воспроизводят себя и изменяются (мутируют), но что можно повлиять на частоту их мутирования, например, повышением температуры или действием ионизирующих излучений [20].

В 1928 г. Меллер [21] в статье «Ген как основа жизни» показал, что именно гены (образования неизвестной тогда природы), способные к ауто- и гетерокатализу, положили начало феномену жизни на нашей планете. «Ясно, что, став на эту точку зрения, мы избегаем логических трудностей, связанных с происхождением современной протоплазмы, с ее взаимодействием частей, действующих совместно в направлении продолжения роста и точного воспроизведения целого. Система эта образовалась, так же как и сложная макроскопическая форма высших растений и животных, ... постепенно, шаг за шагом, каждый из которых проверялся по мере того, как в первичных аутокаталитических генах мутация следовала за мутацией. В этом процессе преимущественно выживали, размножались и вновь мутировали лишь те гены, побочные продукты которых оказывались наиболее полезными для дальнейшего воспроизведения... Согласно этому взгляду, который, по-видимому, наилучшим образом выдерживает проверку исчерпывающим анализом, по крайней мере значительная часть протоплазмы явилась вначале лишь побочным продуктом активности генного вещества; ее функция... заключается лишь в питании генов; первичные же, свойственные всякой жизни, тайны скрыты глубже, в самом генном веществе... Мутабильного типа структуры в генном веществе несомненно претерпели в процессе эволюции глубокие изменения и подверглись усложнениям, а под их влиянием, конечно, эволюционировала и протоплазма, но другие структуры – те черты строения гена, которые ответственны за его первичное свойство аутокатализа – должны быть еще и сейчас такими же, какими они были в незапамятные времена, когда зеленая тина еще не окаймляла берегов морей».

Всего через 20 с небольшим лет после этой публикации было установлено, что гены представляют собой отдельные участки молекулы ДНК, размножающиеся путем комплементарного пристраивания друг к другу четырех видов нуклеотидов; гены мутируют, когда происходят ошибки в этом процессе; они управляют синтезом разного рода белков, составляющих протоплазму, переключаясь время от времени с аутокатализа (построения собственных копий) на гетерокатализ (построение инородных молекул) путем синтеза РНК и, с ее помощью, молекул белка.

Сейчас все это хорошо известные процессы. Можно ли проводить аналогии между свойствами живых клеток и, например, кристаллов? Рост и размножение кристаллов основаны на присоединении к исходной «затравке» все новых, точно таких же молекул из раствора. Вероятность этого равновесного процесса зависит от температуры и концентрации раствора. Размножение вирусной частицы также зависит от условий окружающей среды. Но вирусы, как и все живые организмы, – открытые системы и с большей эффективностью используют окружающую среду для выживания и размножения. Это касается, например, поиска клетки-хозяина и размножения в ней. Прикрепившись к поверхности живой клетки, вирус с помощью специального белкового устройства впрыскивает в нее свою молекулу ДНК или РНК, содержащую его гены. Гены вируса не только воспроизводят себя, используя синтезируемые зараженной клеткой «кирпичики», но также заставляют эту клетку создавать новые, не свойственные ей белковые молекулы, которые, окружая готовые генетические структуры новых вирусных частиц, создают белковую оболочку вируса, приспособленную для осуществления следующего цикла – заражения других клеток и размножения в них.

Все теории происхождения жизни вращаются вокруг попыток ответить на вопрос: как возникла ДНК и та информация, которая записана в ней [17]?

Поведенческая информация

Генетическая информация и ее изменчивость полностью определила эволюцию всех организмов, ведущих преимущественно прикрепленный образ жизни, т.е. растений и грибов. Однако, с развитием подвижности животных, активации поисков пищевых ресурсов и половых партнеров, все большую роль в их жизнедеятельности начинают играть новые, случайно возникающие ситуации, которые невозможно заранее предвидеть и «запастись» генетически детерминированными ответами на них. Это, видимо, и послужило основой для возникновения поведенческой информации. Поведенческой будем называть информацию, лежащую в основе поступков, контролируемых особенностями нервной системы, которые формируются временно, под влиянием жизненного опыта или процессов научения, например путем подражания родителям или другим сородичам.

С возникновением поведенческой информации роль генетической информации в жизни высших животных начинает изменяться. Теперь все большая роль в их выживании принадлежит не только генетически детерминированным ответным реакциям на те или иные ситуации, но и таким особенностям нервной системы, которые обеспечивают эффективное использование обучения и научения, в том числе решение без предварительного опыта внезапно возникающих задач [22]. Поведенческая информация постепенно играет все большую роль в выживании высших животных, примеры чему можно найти как у классиков [22, 23], так и у наших современников [24-27]. Максимальное развитие поведенческая информация получила у млекопитающих. Мы еще не знаем материальной (точнее, молекулярной) природы носителей этого вида информации и не умеем определять ее количество. Но нет поведения, которое не обеспечивало бы целесообразность поступков высших животных в разных ситуациях. Здесь тоже «работает» дарвиновский отбор: неадаптивные реакции приводят, как правило, к гибели животных, а вместе с ними погибает и «неправильная» информация.

Мы убеждены в том, что именно те генетически детерминированные структуры клеток и особенности организации нервной системы, которые делают ее способной накапливать и использовать поведенческую информацию, являются основой для формирования третьего вида информации – логической, с которой связаны возникновение и эволюция человека.

Логическая информация

Вряд ли можно сомневаться, что человек стал тем, что он есть, только обретя дар речи. «В начале было Слово...» (Иоанн, 1, 1). Первоначально логическая информация, носителем которой является речь, играла роль, скорее всего, лишь для ускорения и упрощения обмена между людьми поведенческой информацией. Но затем эта ее функция отошла на второй план. Основная роль и главная функция логической информации связаны, видимо, с особенностями ее носителя – человеческой речью. Речь, язык присущи только человеку. У других живых организмов (в том числе у обезьян и дельфинов) языка нет – есть лишь сигнальное общение, ничего общего, кроме внешнего сходства, с человеческой речью не имеющее [26]. Уникальная особенность языка, как носителя информации, состоит в том, что он позволяет информации существовать вне зависимости от индивидуумов, ее создающих или использующих. Именно язык создал единый информационный пул планеты, открытый для всех населяющих Землю людей.

Логическая информация не имеет четких границ с другими, неинформационными, языковыми феноменами, относящимися, например, к областям искусства, религии и т.п. Но все эти феномены, при тщательном рассмотрении, выполняют общую функцию содействия распространению и сохранению разных видов логической информации. Такую же роль играют и этика, и мораль, и другие стороны социальной жизни людей [28]. Все это, вместе взятое, оказывает на человека давление, направленное на все большее сплочение, объединение всех представителей человечества в единую общность и развитие единого информационного пула.

Подстать развитию информационного пула идет и реализация логической информации. Операторами, способствующими осуществлению целенаправленных действий и кодируемыми генетической информацией, служат все негенетические компоненты живых организмов. В случае поведенческой информации таким оператором является поведение животных в разных ситуациях. Дли логической информации в роли операторов выступают технологии – вся совокупность технологических приемов и процессов, известных человеку. Эти операторы существуют вне зависимости от желания и воли отдельных людей, как и кодирующая их логическая информация.

Мы сейчас находимся в фазе становления «информационного общества». Все новые достижения логической информации и основанных на ней технологий уже практически полностью объединены в единый информационный пул и единую технологическую систему планеты. Этому соответствует такое же (правда, идущее с некоторым запаздыванием) объединение человечества в разных регионах земного шара. Ведущая роль информации в этом процессе очевидна и не требует доказательств. От предсказаний: «Что нас ожидает завтра?» – мы воздержимся по той простой причине, что наше будущее принципиально непредсказуемо: даже небольшие изменения в информационном пуле, непредвидимые заранее, могут существенным образом видоизменить связанные с ними технологии, а следовательно, и наше с вами существование.

Автогенез информации

Первичные живые организмы возникли на нашей планете более 4 млрд. лет назад. Тем самым предшествовавшая неорганическая эволюция дополнилась эволюцией живых организмов [17], в форме которой выступила новая, ранее не существовавшая на Земле сущность – генетическая информация. Закономерности развития информации позволяют понять, как появились новые виды живых организмов, а по существу -новые варианты генетической информации [28]. Попадая во все более сложные условия, в создании которых информация принимала все большее участие через «наработку» побочных продуктов своей деятельности, живые организмы, подчиняясь естественному отбору, увеличивали количество содержащейся в них информации, повышали ее ценность, оптимизировали эффективность.

Различные варианты генетической информации менялись как количественно, так и качественно. В результате живой мир постепенно распространялся по всей планете. Вслед за прокариотами (бактериями) появились эукариоты – растения, грибы и животные. Количество генетической информации, содержащейся в клетках этих организмов, стремилось к возможному для них максимуму [29]. Для координации действий у одной из групп гетеротрофных организмов – многоклеточных животных – образовалась нервная система. У высших животных поведенческие реакции, играющие все большую роль в их жизнедеятельности, не ограничивались уже теми, которые передаются по наследству, а создавались и самостоятельно, на основании «жизненного опыта», и передавались потомкам через обучение. Так возникла поведенческая информация, по лабильности и скорости передачи существенно превосходящая генетическую.

Поведенческая информация образовалась на основе врожденных поведенческих реакций, генетически запрограммированных в нервной системе. Это – ярчайший пример перехода информации из одной формы в другую, с носителей одной природы (молекулы ДНК) на носители другой природы (нервные клетки). Для высших животных, обитающих в сложной природной среде, умение «вести себя» в тех или иных ситуациях играет такую же роль для выживания, как для простых живых существ «умение» потреблять нужную пищу, строить из нее свое тело и вырабатывать нуклеотиды, необходимые для размножения молекул ДНК. Поведенческая информация позволяла высшим животным не только ориентироваться в окружающей среде, но и взаимодействовать друг с другом в поисках пищи и половых партнеров, в воспитании и обучении потомства, в защите от врагов. Вырабатывались различные сигналы, которыми обменивались друг с другом высшие животные: химические метки, знаки на земле или коре деревьев и, конечно, звуки, имеющие разное значение в разных ситуациях. Так постепенно готовилась почва для формирования речи – способа обмена информацией путем различной последовательности звуков и их комбинаций. Складывалась человеческая речь.

Появление владеющего речью «человека говорящего» означало возникновение нового вида информации – информации логической. Б. Ф. Поршнев [30] связывал появление речи с формированием самого человека. Не труд, а речь сделала человека тем, что он есть. Трудиться может и «бессловесная тварь», не жалея сил и преодолевая разные препятствия для достижения своей цели – построения гнезда или плотины, при охоте за дичью. Но организовать труд, передавать друг другу уже приобретенные трудовые навыки, обобщать опыт и в сжатом виде трансформировать его в понятия – для всего этого необходима речь.

Если генетическая информация породила жизнь, поведенческая – обеспечила разнообразие поведения высших животных, то логическая информация, передаваемая с помощью речи, вначале устной, а затем и письменной, ознаменовала начало эры ноогенеза, эры рождения сферы разума, охватывающего, вслед за биосферой, весь земной шар. На основе логической информации, или, другими словами, на основе накапливаемого человечеством знания, начали развиваться технологии. Этим термином называют искусственно создаваемые человеком структуры и процессы, обеспечивающие его существование, а тем самым и размножение тех фрагментов логической информации, которые вызвали их к жизни. Если технология себя не оправдывает, человек ее отбрасывает, и лежащая в ее основе логическая информация утрачивается (забывается).

Так же, как биологическая эволюция представляет собой лишь «отражение в мире вещей» развивающейся генетической и поведенческой информации, так и техногенез – лишь отражение развития логической информации, существующей вне отдельных человеческих существ.

Предвидимо ли будущее?

Мы живем в мире неравновесных процессов. Математические задачи при решении нелинейных дифференциальных уравнений, о которых шла речь выше, приводят к области, называемой теорией бифуркаций. Это говорит о том, что если близко от точки равновесия система имеет единственное решение, то вдали от равновесия при некотором значении критических параметров в области неустойчивости она достигает точки бифуркации, начиная от которой для системы открываются новые возможности, приводящие к одному или нескольким решениям. Теория бифуркаций находит бесчисленные приложения начиная от физики, кончая экономикой и социологией. Попробуем построить приблизительные решения для судьбы логической информации.

Судя по аналогии с предыдущими видами информации, можно предположить автотрофное существование логической информации, подобно автотрофному типу питания, избранному растениями. Но у растений переход этот был связан с совершенствованием отдельных индивидуумов, представляющих собой искусные «живые фабрики» по производству глюкозы из воды и углекислого газа (с помощью квантов солнечного света) и использующих этот продукт для энергообеспечения синтеза молекул, слагающих их тела. В случае же логической информации иной путь к автотрофности – возникновение технологий, использующих тот же солнечный свет (а может быть, и термоядерный синтез) как источник энергии и «подручное» неорганическое сырье для создания сначала – систем жизнеобеспечения человека, а затем, возможно, и для строительства самовоспроизводящихся автоматов. Следует, однако, подчеркнуть, что автотрофность человечества – это такая же вольная фантазия, как и все другие футурологические рассуждения. Единственное, чему нас учит история, – это непредсказуемость будущего.

Пусть читатель не судит очень строго нашу попытку, в меру понимания, представить эволюцию информации, в особенности последний, биологический, этап ее развития. Нашей задачей мы считали не столько ответить, сколько поставить вопросы эволюции, используя идеи из разных областей знания.

Литература

1. Шеннон К. Математическая теория связи // «К. Шеннон. Работы по теории информации и кибернетике». М.: И ИЛ, 1963. С. 243-332.

2. Бриллюэн Л. Научная неопределенность и информация. М.: «Мир», 1966.

3. Кадомцев Б. Б. Динамика и информация. Редакция журнала «Успехи физических наук», 1997.

4. Kolmogorov А. N. Infomation transmission. V.I, 1965. № 3.

5. Zurek W. H. Complexity, Entropy and Phisics of Information (Ed. W. H. Zurek). Addison-Wesley. 1990.

6. Дастр Н. Жизнь материи. Краткий систематический словарь биологических наук. Ч. 3. СПб.: 1904. С. 5-31.

7. Лункевич В. В. Основы жизни. Ч. 1., М.-Л.: 1928

8. Дриш Г. Витализм. Его история и система. М.: 1915.

9. Харкевич А. А. О ценности информации. Проблемы кибернетики. Вып. 4, М.: Физматгиз, 1960. С. 53-72.

10. Корогодин В. И. Определение понятия «информация» и возможности его использования в биологии. Биофизика, 1983, Т. 28., вып. 1, С. 171-177.

11. Prigogine I. Introduction to Nonequilibrium Thermodynamics. Wiley-Interscience. NY. 1962.

12. Баблоянц А. Молекулы, динамика и жизнь. М.: «Мир», 1970.

13. Моисеев Н. Расставание с простотой. М.: Аграф. 1998.

14. фон Нейман Дж. Общая и логическая теория автоматов. В кн.: Тьюринг А. Может ли машина мыслить? М.: Гос. изд. физ.-мат. лит., I960, С. 59-101.

15. Винер Н. Кибернетика, или управление и связь в животном и машине. М.: «Советское радио», 1968.

16. Серавин Л. Н. Теория информации с точки зрения биолога. Л.: Изд. Лен. унив., 1973.

17. Эйген М., Шустер П. Гиперцикл. М.: «Наука», 1980.

18. Шредингер Э. Что такое жизнь? М.: Изд. Ин. Лит.. 1947.

19. Тимофеев-Ресовский Н. В., Циммер К. Г., Дельбрюк М. О природе генных мутаций и структуре гена. В кн: Н. В. Тимофеев-Ресовский. Избранные труды. М.: «Медицина», 1996. С. 105-153.

20. Меллер Г. Д. Проблема изменчивости гена. В кн.: Г.Д.Меллер. Избранные работы по генетике. М.-Л.: Огизсельхозгиз, 1937, С. 178-205.

21. Меллер Г. Д. Ген как основа жизни. // Г. Д. Меллер. Избранные работы по генетике. М.-Л.: Огизсельхозгиз, 1937, С. 148-177.

22. Северцов А. Н. Эволюция и психика. М.: Изд. Собакиных. 1922.

23. Северцов А. Н. Морфологические закономерности эволюции. В кн.: А.Н. Северцов, Собр. сочинений, Т. 5, М.-Л.: Изд. АН СССР. С. 210-216.

24. Tinbergen N. The Study of Instinct. Oxf.: 1969.

25. Лоренц К. 3. Кольцо царя Соломона. М.: «Знание», 1978.

26. Панов Е. Н. Этология – ее истоки, становление и место в исследовании поведения. М.: «Знание», 1975.

27. Крушинский Л. В. Биологические основы рассудочной деятельности. М.: Изд-во МГУ, 1977.

28. Корогодин В. И. Информация и феномен жизни. Пущшо: 1991.

29. Korogodin V. I., Fajszi Cs. Int. J. System set, 1986, v.17, №12. P. 1661-1667.

30. Поршнев Б. Ю. О начале человеческой истории (Проблемы палеопсихологии). М.: «Наука», 1976.

ИСТОРИЧЕСКАЯ СПРАВКА

Термин «информация»

Термин «информация» пришел к нам из латинского языка (informatio), и обычно переводится как «представление», «понятие» (о чем-либо), «изложение», «сведения», «осведомление», «сообщение» и т.п. Термин этот интуитивно ясный, обладает широчайшим смысловым полем и поэтому столь же трудно поддается определению, как и его русские синонимы. В. В. Налимов [1] приводит несколько попыток определить понятие «информация», предпринятых разными авторами, ни одну из которых нельзя признать удавшейся. «Даже эта совсем небольшая подборка определений понятия «информация», – пишет он, показывает, сколь полиморфно по своему смысловому значению это слово. Здесь развитие полиморфизма связано прежде всего с тем, что ни одно из определений не отвечает нашим интуитивным представлениям о смысле этого слова. И всякая попытка определения приписывает этому слову совершенно новые черты, отнюдь не раскрывающие, а суживающие и тем самым затемняющие его смысл и уже безусловно увеличивающие семантический полиморфизм этого слова» (стр. 127). Это отражает саму специфику феномена, обозначаемого этим термином.

Определить понятие можно двумя способами – либо сведя его к более элементарным (фундаментальным), либо перечислив круг явлений, к нему относящихся. В основе обоих видов определения лежит возможность расчленить, подразделить смежные понятия или феномены, т.е. дискретность. Дискретность, как известно, фундаментальное свойство материального мира, т.е. мира вещей и энергии. Именно дискретность природных явлений составляет базу всех естественных наук. В случае информации дело обстоит иначе. Слагается ли информация из отдельных дискретных составляющих, или это непрерывный, точнее, – неразрывный поток, лишь искусственно расчлененный на отдельные сообщения или сведения? Ответить на этот вопрос мы не можем. Но, может быть, именно эта особенность информации отражает тот факт, как пишет Н. Винер [2], что «Информация есть информация, а не материя и не энергия» (стр. 201), т.е. не принадлежит миру вещей. Ниже мы еще не раз к этому будем возвращаться. Сейчас же важно понять, почему никто из упомянутых выше ученых, стоявших у истоков теории информации, не попытался дать строгого определения этого термина.

Так складывалась теория, объект которой не был определен. В науке впервые возникла ситуация, подобная той, которая характерна для древнееврейской религии: Бог имеет множество имен, но ни одно из них нельзя произносить вслух. В области религии это вполне допустимо. В науке же все идеи и направления постоянно дискутируются. Мы дадим главные идеи из разных областей, где может быть использован этот термин.

Формула Шеннона

Возникновение классической теории информации было индуцировано развитием технических систем связи, призванных служить обмену информацией между людьми. Подчеркнем – технических систем, работа которых определяется законами физики, т.е. законами материального мира. Задача оптимизации работы таких систем требовала, прежде всего, решить вопрос о количестве информации, передаваемой по каналам связи. Поэтому вполне естественно, что первые шаги в этом направлении сделали сотрудники Bell Telephon Companie – X. Найквист, Р. Хартли и К. Шеннон [3].

В 1924 г. X. Найквист предложил измерять количество информации, приходящееся на одну букву текста, передаваемого по каналу связи, величиной Н-1/п, где п – число букв в используемом языке. Спустя четыре года Р. Хартли, исходя из требования аддитивности, в качестве такой меры начал применять логарифм этой величины, т.е. log(1/n). Двадцать лет спустя, в 1948 г., К. Шеннон для этой же цели ввел величину

![]() (6)

(6)

где Hi – количество информации, связанное с i-ой буквой алфавита, pi – частота встречаемости этой буквы в данном языке, q - основание логарифмов, а k – коэффициент пропорциональности, величина которого зависит от q и от избранных единиц измерения количества информации; знак «минус» перед k поставлен для того, чтобы величина Hi всегда была положительной. Тогда суммарное количество информации для сообщения, состоящего из М букв, будет

![]() (7)

(7)

где mi – число i-х букв в сообщении ![]()

К. Шеннон показал, что с увеличением длины сообщения М почти всегда будет иметь «типичный состав»: (тi/М → рi). Следовательно,

![]() (8)

(8)

В случае бинарного кода, когда n = 2, а р1 = р2 = 0,5, q=2 и k=1, количество информации Нм становится равным М и выражается в так называемых бинарных единицах – битах.

Приведенные формулы послужили К. Шеннону основанием для исчисления пропускной способности каналов связи и энтропии источников сообщений, для улучшения методов кодирования и декодирования сообщений, для выбора помехоустойчивых кодов, а также для решения ряда других задач, связанных с оптимизацией работы технических систем связи. Совокупность этих представлений, названная К. Шенноном «математической теорией связи», и явилась основой классической теории информации.

Теперь обратим внимание на три характерные черты этой работы К. Шеннона. Во-первых, в ней отсутствует определение понятия «информация». Во-вторых, термин «количество информации» здесь используется как синоним статистических характеристик букв, составляющих сообщение. В-третьих, по отношению к источнику сообщений здесь применяется слово «энтропия». Черты эти, несущественные в контексте математической теории связи, оказали значительное влияние на судьбу теории информации.

Отсутствие определения понятия «информация» в работах К. Шеннона и его предшественников, по-видимому, довольно естественно – они в нем просто не нуждались. Ведь работы эти были посвящены не теории информации, а теории связи. То, что по каналам связи передают осмысленные сообщения, т.е. информацию, было очевидно, – ведь для этого их и создавали. Замечательной особенностью каналов связи является то, что по ним можно передавать любую информацию, пользуясь ограниченным числом сигналов или букв. При этом передают по каналам связи именно буквы, сигналы, а не информацию как таковую. Объекты передачи, следовательно, имеют материальную, физическую природу – обычно это модуляции напряженности электрического тока. Ответа требовал не вопрос «Что такое информация?», а вопрос «Какое количество информации можно передать в единицу времени, пользуясь данным набором сигналов?». Предложенное К. Шенноном определение «количества информации» (6) хорошо согласовывалось с дискретной[1] природой сигналов, обычно передаваемых по каналам связи. И в то же время, такая мера «количества информации» создавала ощущение, не встречающее сопротивления на психологическом уровне, что чем реже происходит данное событие – появление данного сигнала на выходе канала связи, тем больше это событие «несет с собой» информации.

Со всем этим можно было бы вполне согласиться, если бы не одно обстоятельство: отдельные сигналы или буквы, передаваемые по каналам связи, сами по себе не несут той информации, для обмена которой существуют системы связи. Информацию содержат лишь сочетания сигналов или букв, причем отнюдь не любые, а лишь осмысленные, наполненные определенным содержанием. Введение единой меры количества информации, содержащейся в сообщениях, меры, не зависящей от их семантики, как будто бы блестяще решало задачу соизмеримости бесконечного количества возможных различающихся по смыслу сообщений. И в то же время введение такой меры создавало видимость дробления, квантируемости информации, видимость возможности оценивать ее количество как сумму элементарных количеств информации, связанных с каждой отдельной буквой содержащего ее сообщения.

Напомним, что ко времени выхода в свет работы К. Шеннона [3] научная общественность была уже подготовлена к ее восприятию. Зарождавшаяся тогда же кибернетика, или «наука об управлении и связи в животном и машине» [2], уже использовала термин «информация» для обозначения тех сигналов, которыми могут обмениваться между собой люди или животные, человек и машина, или сигналов, воспринимаемых животными или машиной с помощью специальных рецепторов из окружающей среды с целью оптимизировать свое «поведение». Уже был пущен в оборот термин «генетическая информация» [4]. Бурное развитие самых разных технических систем связи (телеграфа, телефона, радио, телевидения) остро нуждалось в ограничении присущего понятию «информация» полиморфизма в целях разработки все более совершенных методов ее передачи, приема и хранения. Всем этим запросам, казалось, прекрасно соответствовала шенноновская концепция количества информации.

Однако надо ясно представить себе, что, не давая определения понятию «информация» и в то же время называя «количеством информации» частотную характеристику букв кода, К. Шеннон как бы создавал возможность для отождествления двух совершенно разных по своей природе феноменов информации как семантики сообщения и «информации» как частоты осуществления какого-либо события. Это делало возможной подмену терминов, что и было быстро реализовано. Уже через несколько лет французский физик Л. Бриллюэн [5,6] в качестве основного достоинства новой теории называл отождествление информации с величиной, обратной частоте осуществления какого-либо события. Термин «информация» в указанном выше смысле окончательно слился с термином «количество информации».

Формула К. Шеннона (6) по структуре своей подобна формуле, предложенной Л. Больцманом для выражения количества энтропии. Это формальное сходство послужило К. Шеннону поводом называть «энтропией», по аналогии с физической энтропией, свойство источника сообщений порождать в единицу времени то или иное число сигналов на выходе, а «энтропией сообщения» – частотную характеристику самих сообщений, выражаемую формулами (6) и (7).

Кажущаяся простота предложенного К. Шенноном решения проблемы измерения количества информации создавала видимость столь же легкого решения и других связанных с использованием термина «информации» проблем. Это и породило ту эйфорию, ту шумиху вокруг зарождающейся теории информации, характерную для пятидесятых годов, которую одним из первых заметил сам К. Шеннон и против которой было направлено его провидческое эссе «Бандвагон» [7].

Информация и энтропия

Своей зрелости классическая теория информации достигла к середине пятидесятых годов. Главная причина столь быстрого «созревания» – простота и элегантность ее математического аппарата, опирающегося на теорию вероятности.

Отсутствие строгого определения понятия «информация» создавало впечатление, что объектом теории информации является нечто, имеющее мало общего с тем, что называют информацией в обыденной жизни. Действительно, если «в быту» доминирует содержательная, смысловая сторона информации, то здесь семантика информации вообще не рассматривалась. Представление об энтропии сообщений, развитое К. Шенноном и вскоре дополненное другими авторами (см. напр. [8-10]), как бы открывало возможность для отождествления понятия «информация» с понятиями «разнообразие» и «термодинамическая энтропия». Это порождало соблазн распространения классической теории информации далеко за пределы теории связи, в том числе на явления неживой и живой природы и даже на различные области искусства [11-13].

Два утверждения характерны для классической теории информации периода зрелости. Первое это постулирование «всюдности» информации. Второе утверждение – это то, что мерой количества информации, связанной с тем или иным объектом или явлением, может служить редкость его встречаемости или сложность его структуры. Эти утверждения можно назвать постулатами классической теории.

Указанные постулаты, а также следствия из них, наиболее полно были изложены Л. Бриллюэном в его книгах [5, 6]. Прежде всего, за универсальную меру количества информации Л. Бриллюэн принял величину I = klnP, где Р - вероятность осуществления некоторого события или «сложность устройства» какого-либо объекта, k - постоянная, величина которой зависит от выбора системы единиц измерения, a ln - натуральный логарифм. Далее Л. Бриллюэн обратил особое внимание на сходство указанной формулы с формулой Л. Больцмана для исчисления количества энтропии S = klnW, где W - число микросостояний некоторой системы, соответствующей ее макросостоянию, а k - «постоянная Больцмана», равная 1,4·10-16 эрг-град-1 или 3,3·10-24 энтропийных единиц (1 э.е. = 1 кал'град-1). Отсюда Л. Бриллюэн сделал вывод, что, приняв k = 3,3·10-24 э.е., мы получим возможность выражать количество информации в энтропийных единицах (1 бит = 2,3·10-24 э.е.), а величину энтропии, напротив, в единицах информационных (1 э.е. = 4,3·1023 бит). Затем он сделал последний шаг в построении «негэнтропииного принципа»: сформулировал утверждение, согласно которому информация – это не что иное, как энтропия с обратным знаком, или негэнтропия.

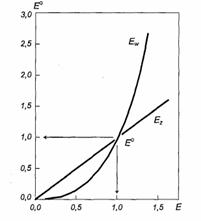

Используя вероятностный подход, мы проведем следующие рассуждения. Пусть физическая система имеет W возможных состояний. Увеличение информации о ней, что было бы эквивалентно фиксации в определенном состоянии, приведет к уменьшению энтропии системы. Другими словами,

I + S = const. (9)

Чем больше известно о системе, тем меньше ее энтропия. Важно еще одно обстоятельство. Утрачивая информацию, мы увеличиваем энтропию системы. Увеличивать информацию о системе мы можем, лишь увеличивая количество энтропии вне этой системы, во внешней среде, причем всегда

![]()

Формула Шеннона для определения количества информации (2) и формула Больцмана S = lnW для случая, когда вероятности отдельных состояний системы различаются (3), формально совпадают. Мы замечали, что они имеют совершенно различный смысл: информация (2) соответствует одному единственному состоянию системы из всех возможных W, мера этой информации I = lnW. Энтропия (3) соответствует возможности нахождения системы с некоторой вероятностью I/W в каждом из доступных состояний. Информация (2) и энтропия (3) оказались равны между собой, потому, что I соответствует максимальной информации одного единственного состояния, а 5 определена по множеству всех состояний.

В замкнутой системе (возьмем, например, текст) увеличение энтропии приводит к «забыванию» информации, и мы приходим к соотношению I + S = const. В соответствии со вторым законом термодинамики энтропия замкнутой системы не может убывать со временем. Поэтому в замкнутых системах соотношение (9) может сдвигаться только к забыванию информации. Это означает, что рождение новой информации требует выхода за пределы изолированной системы.

Мы рассмотрели соотношение I + S = const с точки зрения второго закона термодинамики. Формулу Шеннона можно было бы назвать «физической информацией». Колмогоров [15] ввел понятие «алгоритмической информации». Алгоритмическую информацию можно рассматривать как меру алгоритмической хаотичности. Алгоритмическая информация практически совпадает с информацией по Шеннону.

Поясним эти понятия и их соотношение на двух примерах из живого мира. Предположим, что мы хотим определить радиочувствительность клеток популяции дрожжей. Мы ставим эксперимент: делаем суспензию клеток, облучаем ее, высеваем клетки на чашки Петри с питательной средой, затем определяем радиочувствительность клеток по числу выросших колоний. В ходе этого эксперимента мы заставляем геном клеток дрожжей работать по определенной схеме, одной единственной для каждой клетки. Тем самым мы выбираем и фиксируем одно единственное состояние из всех возможных. Этот эксперимент, который выявляет реакцию данных клеток на облучение, сводит все возможные состояния макромолекул, характеризующиеся некой максимальной энтропией, к одному единственному. Он может быть проведен за счет внешних ресурсов (питательной среды, источника облучения, работы лаборанта и т.д.). Второй пример – завоевание электората перед выборами. Хаотичные настроения толпы, характеризующиеся максимальной энтропией в обычное время, после агитации средствами массовой информации (накачивание внешней 7) перед выборами сменяются крайней политизацией. После выборов определяется количество проголосовавших за того или иного кандидата – поведение электората соответствует максимуму «информированности» о том или ином кандидате, какое-то количество неголосовавших составляет инертную константу.

Кратко резюмируя изложенное, можно заключить, что рождение новой информации всегда происходит в открытых системах, где параметры порядка становятся динамическими переменными.

В следующем параграфе мы рассмотрим системы с диссипацией избыточной внутренней энтропии.

Диссипативные структуры

Пусть будет некоторая открытая система, из которой постоянно удаляется шлак избыточной энтропии за счет роста энтропии внешней среды. Эта система является «диссипативной структурой». Пригожий с сотрудниками [16, 17] показали, что диссипативными структурами будут являться все разнообразные колебательные, пространственно организованные и пространственно-временные упорядоченные системы.

Для возникновения диссипативных структур необходимы следующие условия:

1. система должна быть открытой и находиться вдали от термодинамического равновесия;

2. в системе должны протекать различные каталитические и кросс-каталитические процессы, а также наблюдаться регуляция по типу обратной связи;

3. после некоторого критического значения параметров системы или какого-либо внешнего воздействия состояние системы становится неустойчивым и система может перейти в новое стационарное состояние, режим которого соответствует упорядоченному состоянию.

Под влиянием флуктуации отдельные элементы системы, взаимодействуя, обнаруживают свойства, характеризующие систему в целом, которые невозможно предсказать на основании свойств ее отдельных элементов. Такие структуры хорошо описываются нелинейными дифференциальными уравнениями. Примеры диссипативных структур можно взять из разных областей – физики, химии, биологии.

Одной из давно известных таких самоорганизующихся структур является реакция Белоусова-Жаботинского [18, 19]. Бросается в глаза большое число промежуточных соединений системы, которые соответствуют такому же числу дифференциальных уравнений. Для каждого из этих уравнений константа скорости должна быть получена из эксперимента. Один из этапов реакции является автокаталитическим.

Молекулярная эволюция. Гиперциклы Эйгена

В 1971 г. М. Эйген [20] сформулировал последовательную концепцию предбиологической молекулярной эволюции. Эйген распространил идеи дарвиновского отбора на популяции макромолекул в первичном бульоне. Далее он показал, что кооперирование молекул в «гиперциклы» приводит к компартментализации в виде отдельных клеточных единиц. Гиперцикл – это средство объединения самовоспроизводящихся единиц в новую устойчивую систему, способную к эволюции. Он построен из автокатализаторов, которые сочленены посредством циклического катализа, т.е. посредством еще одного автокатализа, наложенного на систему.

Дарвиновский отбор, являющийся предпосылкой для возникновения гиперциклов, на молекулярном уровне может иметь место в системах, обладающих следующими свойствами:

1. метаболизмом – система должна быть далеко от равновесия. Образование и разложение молекулярных видов должны быть независимы. Отбор должен действовать только на промежуточные состояния, которые образуются из высокоэнергетических предшественников и разрушаются в низкоэнергетические отходы. Система должна использовать освободившуюся энергию и вещества;

2. самовоспроизведением – способностью инструктировать свой собственный синтез;

3. мутабилъностью, которая всегда сопутствует самовоспроизведению. Ошибки копирования – основной источник новой информации. Образование и отшлифовка эйгеновских гиперциклов привели к созданию аппарата трансляции. Образование вслед за этим клеточной мембраны завершило предбиологический период эволюции.

Семантика

Вернемся снова к формуле Шеннона (6) и проанализируем текст «Завтра будет буря». Действительно, осмысленность или информация текста «Завтра будет буря» очевидна. Достаточно, однако, сохранив все элементы (буквы) этого сообщения, переставить их случайным образом, например, «рдеа Звубуб траяи», как оно утратит всякий смысл. Но бессмысленной информации не бывает. Согласно же формуле (7) оба предложения содержат одинаковое «количество информации». О какой же информации здесь идет речь? Или, вообще, можно ли говорить об информации по отношению к разрозненным элементам сообщения?..

Очевидно,

отдельные элементы сообщения можно назвать «информацией» лишь при

условии, если перестать связывать информацию с

осмысленностью, т.е. с содержательностью. Но тогда это

бессодержательное нечто вряд ли стоит называть «информацией»,

вкладывая в первичный термин несвойственный ему смысл. Учитывая,

однако, что элементы сообщения реально используются для составления осмысленных

текстов, содержащих информацию, эти элементы (буквы, сигналы,

звуки) удобнее трактовать как информационную тару, которая

может содержать информацию, а может быть и

бессодержательной, пустой [21]. Очевидно, что емкость тары не

зависит от того, заполнена ли она и чем она заполнена. Поэтому

частотную характеристику элементов сообщения ![]()

лучше называть не «количеством информации», а «емкостью информационной тары». Это, кстати, хорошо согласуется с формулой К. Шеннона (7), по которой «количество информации» в данном сообщении не зависит от порядка следования составляющих его букв, а только от их числа и частотных характеристик.

Однако

здесь резонно возникает вопрос, насколько обоснованно считать ![]()

емкостью i-го элемента информационной тары? Судя по работе [3], такой способ измерения количества информации введен скорее из соображений удобств. Коэффициент k здесь играет подсобную роль – его величина зависит от выбора единицы измерения количества информации (или емкости тары) и основания логарифма. Как мы уже отмечали, если за такую единицу принять бит, т.е. информационную емкость одного элемента стандартного бинарного кода, когда р1 =р2 = 0,5, а за основание логарифмов «2», то k=1, и тогда формула (7) приобретет вид Нм = М. В общем же случае эту формулу можно записать как (1), что по смыслу своему представляет собой не что иное, как расчет числа букв бинарного кода, требующегося для записи данного сообщения. При такой интерпретации выбор единицы измерения емкости тары и способа определения этой емкости приобретает обычное звучание, – но, конечно, лишь при условии максимальной компактности кода (когда реже встречающиеся в языке символы заменяются большим числом букв бинарного кода, чем чаще встречающиеся) и только в пределах данного разговорного языка. Сохранится ли это правило перехода от одного кода к другому для разных разговорных языков? А также от одного языка к другому?

Заметим, однако, два обстоятельства в данном примере текста «Завтра будет буря». Первое – текст понятен русскому, но является «китайской грамотой» для китайца. Это говорит о том, что каждый раз, когда мы говорим о семантике, необходимо иметь в виду семантическое родство сообщения и воспринимающей системы.

Второе обстоятельство касается того, что текст – замкнутая система.

Перейдем к открытым динамическим системам. Как мы уже отмечали, в таких системах будут возникать параметры порядка, именно они станут «семантикой информации», адекватной внешней среде. На основании этой новой информации будет идти естественный отбор на выживание этих организованных систем. Дарвиновский отбор накладывает ограничения на объекты всех уровней – физические, химические, биологические и другие [22]. В биологических системах первым уровнем дарвиновского отбора является генетический отбор. В этой монографии мы будем рассматривать биологические системы, начиная с генетической – живой клетки.

Литература

1. Налимов В. В. Вероятностная модель языка. М., «Наука». 1979.

2. Винер Н. Кибернетика, или управление и связь в животном и машине. М., Советское радио, 1968.

3. Шеннон К. Математическая теория связи. В кн.: Работы по теории информации и кибернетике. М., Изд. ин. лит., 1963. С. 243-496.

4. Шредингер Э. Что такое жизнь с точки зрения физика? М., Гос. изд. ин. лит. 1947.

5. Бриллюэн Л. Наука и теория информации. М., Гос. изд. физ.-мат. лит., 1960.

6. Бриллюэн Л. Научная неопределенность и информация. М., «Мир», 1966.

7. Шеннон К. Бандвагон. В кн.: Работы по теории информации и кибернетике. М., Изд. ин. лит., 1963, С. 667-668.

8. Голдман С. Теория информации. М., Изд. ин. лит., 1957.

9. Стратанович Р. Л. Теория информации. М., «Советское радио», 1975.

10. Яглом А. М., Яглом И. М. Вероятность и информация. М., «Наука», 1973

11. Коган И. М. Прикладная теория информации. М., «Радио и связь», 1981.

12. Поплавский Р. П. Термодинамика информационных процессов. М, «Наука», 1981.

13. Седов Е. А. Эволюция и информация. М., «Наука», 1976.

14. Кадомцев Б. Б. Динамика и информация. М.: Ред. ж. УФН, 1997.

15. Колмогоров А. Н. Теория информации и теория алгоритмов. М., «Наука», 1987.

16. Гленсдорф П., Пригожий И. Термодинамическая теория структуры, устойчивости и флуктуации. М.: «Мир», 1973.

17. Баблоянц А. Молекулы, динамика и жизнь. М., «Мир», 1990.

18. Белоусов Б. П. Периодически действующая реакция и ее механизмы. В Сб. рефер. по радиац. мед. за 1958 г. М.: Медгиз, 1959.

19. Жаботинский А. М. Концентрационные автоколебания. М.:«Наука», 1974

20. Эйген М. Самоорганизация материи и эволюция биологических макромолекул. М.:«Мир», 1976.

21. Корогодин В. И. Определение понятия «информация» и возможное его использования в биологии. Биофизика, 1983, т. 28, с. 171-178.

22. Моисеев Н. Н. Алгоритмы развития. М., «Наука», 1987.

ИНФОРМАЦИЯ И ЕЕ СВОЙСТВА

Дуальность окружающего мира

События, происходящие вокруг нас, можно разделить на два класса: изменения и целенаправленные действия. В соответствии с этим и объекты, окружающие нас, можно подразделить на те, которые могут только изменяться, и те, которые могут действовать целенаправленно. Ко второму классу относятся события из мира живой природы [1-3].

Изменениями обычно называют все, что происходит с окружающими нас объектами и с нами самими с течением времени, независимо от особенностей и скорости отклонения от того состояния, которое мы можем зафиксировать в некоторый данный момент. Изменяется все: «Ничто не вечно под луной». Происходят изменения в соответствии с законами физики и химии, которые, таким образом, и управляют изменениями окружающего нас мира. Физическая и химическая природа объектов и условий, в которых они находятся, с неизбежностью определяют направления, характер и скорость их изменений, будь то атом, человек или Вселенная. Конечным итогом таких изменений всегда и неизбежно является гибель, распад или иная форма превращения материального объекта. Но некоторые объекты способны так изменяться во внешней среде, что одни процессы в них идут чаще, другие реже, адекватно условиям среды.

Рассмотрим по одному примеру из первого и второго классов объектов: рост кристаллов и размножение бактерий. Кристаллы могут расти и размножаться, присоединяя к «матрице» –кристаллу все новые молекулы из исходного раствора. Этот процесс является равновесным. Кристаллы не могут разлагать окружающие их вещества на составные части, а уж из этих частей строить дальше самих себя или свое подобие. Но именно так поступают живые организмы, – в данном примере бактерии, – они разлагают окружающие их вещества и уже из полученных «элементарных кирпичиков» строят заново те молекулы, которые используют для своего роста и размножения.

Кристаллы для своего роста используют то, что уже есть, живые организмы создают то, что им нужно, используя окружающие их вещества для получения строительного материала и свободной энергии.

Различные живые организмы, попав в ту или иную среду, всегда вызывают в ней изменения, так или иначе различающиеся между собой – различия эти не случайны, а определяются природой организма, и всегда подчинены достижению некоторой цели. Здесь будущее как бы доминирует над прошлым. При этом последовательность таких целенаправленных действий, как бы ни казалась она простой или сложной, всегда имеет в виду конечную цель – размножение данного организма. Когда эта цель достигнута, все начинается сначала и завершается тем же, т.е. новым циклом размножения. Таким образом, конечная цель деятельности любого живого организма – его самовоспроизведение.

Чтобы понять природу того или иного изменения, достаточно ответить на вопрос: «Почему?». Вопросы типа «Почему светит Солнце?», «Почему ржавеет железо?», «Почему орел может летать?» полностью исчерпываются, если рассмотреть химическую и физическую природу соответствующих явлений. Но вопросы типа «Для чего светит Солнце?» или «Для чего идет дождь?» лишены смысла и ответов не имеют, тогда как вопросы типа «Для чего летает орел?» вполне осмысленны и предполагают тот или иной ответ.

Дело в том, что полет орла, как и другие действия живых объектов, относятся к типу целенаправленных. Когда же речь идет о целенаправленных действиях, доминирующее значение приобретает вопрос «Для чего?». Ответ на вопрос «Почему?» здесь не может объяснить природу события, он может позволить понять лишь механизм его осуществления. «Для чего цветут розы?», «Для чего поют соловьи?» – вопросы всем понятные и, кстати сказать, давно получившие ответы. Осуществляют же растения и животные те или иные действия потому, что они устроены так, а не иначе, для того, чтобы их осуществлять...

Казуальность и телелогичность – вот те два принципа, которые управляют окружающей нас действительностью. Царство казуальности, или причинно-следственных связей, где настоящее определяется прошедшим, охватывает всю Вселенную, но полностью подвластны ему лишь объекты неживой природы. В должном месте и в должное время в этом царстве возникают и развиваются островки иного мира, где настоящее подчиняется будущему, где те или иные события происходят не только «потому, что...», но также «для того, чтобы...». Этот вторичный по отношению к миру косной материи мир жизни становится все могущественнее, он постепенно как бы вбирает, трансформирует в себя окружающую среду, все в большей степени контролируя происходящие в ней изменения, направляя их в нужное ему русло.

Чтобы избежать возможных недоразумений, заметим, что антропоморфизм таких терминов, как «контролирует», «стремится» и т.п., отнюдь не означает, что весь органический мир наделен свободой воли или способностью осознавать свои действия. Просто нет других терминов, более адекватно отражающих те свойства, которые являются общими для всех живых существ, от вирусов до человека, независимо от того, осознаются они соответствующими объектами или нет.

Целенаправленность и целесообразность

Таким образом, мы наметили свойство, необходимо присущее всем живым организмам. Свойство это – осуществлять целенаправленные действия. Обеспечивается это тем, что живые организмы устроены так, а не иначе, для того, чтобы иметь возможность это делать, т.е. организованы соответствующим образом, или целесообразно.